GeForce?y mają problem z DX12 [WIDEO]

![GeForce?y mają problem z DX12 [WIDEO]](https://staging.cdaction.pl/wp-content/uploads/2025/03/57f8cfea-8005-422b-b1d0-e6f08c58d2fd.jpeg)

Na przejściu do DX12 GeForce’y zyskują bowiem minimalnie, podczas gdy Radeony stają się mniej więcej dwukrotnie szybsze. Można by złośliwie wytknąć, że przynajmniej w części jest to zasługa wręcz zadziwiająco słabej wydajności w DX11, ale nie od dziś wiadomo, że sterowniki AMD czasami zawodzą (ehm, Project: CARS, ehm…). W każdym razie jeśli chcesz się dokładniej wpatrywać w wykresy (stworzone przez PC Perspective), znajdziesz je na samym dole, teraz natomiast przejdziemy do najnowszych rewelacji.

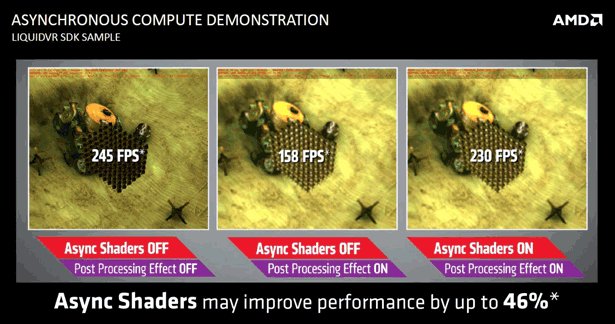

Otóż Oxide Games stwierdziło, że dziwne wyniki kart Nvidii to wynik niepełnego wsparcia dla DX12. Konkretnie – braków w implementacji funkcji Async Shaders. To – według OG – jedna z kluczowych zalet DX12, pozwalająca na asynchroniczne wykonywanie zadań przez GPU, co wpływa na skrócenie czasu tworzenia grafiki i minimalizację opóźnień. AMD nie ma z tym problemów, a zalety przedstawiło na filmiku (ma polskie napisy).

Jeśli nie chcesz oglądać całego filmu, jest jeszcze slajd, z którego jasno wynika, że pozwala to uzyskać wzrost wydajności o prawie 50%.

Problem ze zgodnością z Async Shaders dotyczyć ma wszystkich kart Nvidii, nawet najnowszych, z serii 900. Bo choć sterownik zgłasza, że jest ona dostępna ( „zieloni” nigdy zresztą nie mówili, że jest inaczej, a oficjalnie z DX12 zgodna jest także seria 600 i 700 – tabelka ze szczegółami dostępna jest tutaj), ale skorzystanie z niej prowadzi do katastrofalnego spadku wydajności.

Jak żyć?

Przede wszystkim nie panikować. DX12 daje wprawdzie znacznie mniejsze możliwości optymalizacji sterowników, bo przecież chodzi w nim o bezpośredni dostęp do sprzętu, ale nie znaczy to, że jest to niemożliwe. Zwłaszcza że na forum Beyond3D pojawiły się już informacje (odkryte empirycznie przez jednego z użytkowników) o tym, że GeForce’y jednak asynchroniczne shadery wspierają, tyle że są w stanie jednocześnie obsługiwać do 32 kolejek, a nie 96-128 jak Radeony. W dodatku jeśli GTX 980 Ti wykorzysta właśnie 32, będzie szybszy niż Fury X wykorzystujący ile tylko się da.

Jeśli ta informacja się potwierdzi, problem okaże się znacznie mniejszy, niż mogłoby się wydawać na pierwszy rzut oka. Zwłaszcza że to właśnie karty GeForce stanowią większość na rynku PC, więc nie zdziwiłbym się, gdyby liczba kolejek była dostosowywana właśnie do nich, zwłąszcza że Radony też sobie z 32 wątkami bezproblemowo radzą. Oczywiście możne to stanowić problem w przypadku konwersji z konsol (które Radeonami stoją), ale… pożyjemy, zobaczymy. Pecetowy Batman i bez tego miał problemy.

I jeszcze jedno. Całą tą sytuację najciekawiej skomentował na Twitterze Robert Hallock: „There is no such thing as full support for DX12 today” (czyli w dość luźnym tłumaczeniu: pełna zgodność z DX12 obecnie nie istnieje).

No dobrze, ale kto to w ogóle jest? Otóż pan Hallock jest Head of Global Technical Marketing.

W AMD…

A oto jeszcze obiecane wyniki testów w Ashes of the Singularity (kliknij aby powiększyć):

Czytaj dalej

20 odpowiedzi do “GeForce?y mają problem z DX12 [WIDEO]”

Dodaj komentarz

Musisz się zalogować, aby móc dodać komentarz.

„…Zwłaszcza że to właśnie karty GeForce stanowią większość na rynku PC…” Właśnie odkryliśmy źródło dlaczego tyle jest fanbojów „zielonych”. Na chwile obecną mogę krzyknąć Czerwoni Górą!

To ma nV problem, co zrobić z tymi kartami, bo ludzie będą oczekiwać nowych układów z pełnym wsparciem. Sam chciałem zrobić upgrade z 700>900, ale teraz chyba poczekam. Może nie na nowe jednostki, bo mnie do W10 nie ciągnie, ale może jakiś spadek cen „starych” układów? Mam nadzieję, że AMD rynkowo wymusi taką obniżkę 😉 .

Tak szczerze to kogo obchodzą dzisiaj takie testy. Na laptopie za 3500 zł chodzi wszystko, podpinam monitor, klawiaturę i mysz, mam to samo co na blaszaku. Czasy wymiany kart graficznych (i procków) w komputerach odeszły bezpowrotnie. Kupuje się nowy sprzęt w całości z systemem i się gra. Kiedyś znałem parametry procków, kart graficznych, kości. Dzisiaj koło pióra mi to lata. I cieszę się z tego. |Do wszystkich gier to wystarcza zupełnie.

@jank|Obchodzi to każdego kogo to interesuje. Uwierz, że nie tylko grami ludzie żyją.

@jank|Co to za laptop za 3500 zł? Sam mam kompa z przed roku za trochę ponad 4000 zł, podpinam monitor klawiaturę i mysz, a w takim Wiedźminie 3 musiałem iść na kompromis jakość/fps, gdyż na docelowych dla mnie ustawieniach nie osiągnąłem pełnych 60 fpsów. Wątpię czy na na lapku za tą cenę otrzymał bym połowę tego. Nie mówiąc już o możliwości kręcenia czy monitorach 120hz/144hz bądź 4k. Niestety laptopy dalej są daleko w tyle za blaszakami.

@Paku93|Jak ktoś koniecznie musi grać w 4K, ultra i 60FPS to faktycznie laptop się nie nadaje. Ale jak komuś wystarczą średnie i 30FPS w 1366×768 to w wieśka 3 pogra tak na lapku za 2500zł + dalej ma sprzęt który może zabrać pod pachą na studia czy do pracy. |@jank|Ehh mam tak samo, teraz można kupić cokolwiek i dalej mieć znośny sprzęt na lata

@jank Jako grafik mogę cię zapewnić że jednak niektórych to interesuje, a nawet musi. Co prawda nie jest tak, że sprzętowo ogarniam wszystko, ale wiem, że aby komfortowo wykonywać swoją pracę muszę zapewnić sobie standard więcej niż wystarczający 🙂

Rozpoczął się rok szkolny, więc radzę autorowi newsa się tam wybrać na lekcje matematyki, bo jeśli coś jest dwa razy szybsze, to oznacza wzrost o 100% a nie 50%. Żeby jeszcze ułatwić sprawę napiszę, że karty AMD na DX12 są w najlepszym przypadku o prawię połowę szybsze. A skoro już przy DX12 i kartach AMD jestem, to powiem, że się cieszę, bo kupiłem R9 280X i miło patrzeć, że karta na dłużej mi starczy zanim ją wymienię.

@RX1337|Czepiasz się. 50% odnosi się tylko do zamieszczonego slajdu, który faktycznie przedstawia taki przyrost. Autor podsumował tylko to, co znajdowało się na obrazku, więc się nie pomylił.|”Żeby jeszcze ułatwić sprawę napiszę, że karty AMD na DX12 są w najlepszym przypadku o prawię połowę szybsze” Znaczy, że co? Karty ścigają się „setkę” i AMD wyprzedzają NVidię o połowę swojej długości? Łatwo jest wyśmiewać, uwierz 😉

Spokojnie, nvidia już szykuje nowe karty. Pascal i Volta tak się zwą one. Niby mają osiągać 1+tb/s. A amd coś z 700gb/s. Aż strach się bać. Do tego jeszcze nowe procesory Zen(amd) i Cannonlake(Intel). W 2016 konsolki do gier chyba odejdą w zapomnienie.

@Syskol|Mnie nie zadowala ani 1366×786 ani średnie detale, więc dla mnie dalej laptop to strata pieniędzy, nie mówiąc już o tym że ma to tendencje do grania się i wymaga częstego czyszczenia, a rozkręcanie wielu modeli zajmuje trochę czasu. |Jak widać mnie np. obchodzą takie testy sam kupiłem gtx970 chwile po premierze, gdybym składał kompa dziś, zastanowił bym się nad konkurencją.

Może DX12 faktycznie więcej daje kartom AMD, ale nie czyni ich lepszymi od GeForce’ów. Powyższy test R9 390X z GTX 980 dowodzi tylko, że za sprawą nowej biblioteki Radeony są w stanie dorównać swoim konkurentom. Ktoś może powiedzieć, że to przecież nie ta sama liga, inny przedział cenowy(+/-450zł). Być może, ale owa różnica zwróci się w końcu w rachunku za prąd.

@asrudy: No to powinni to zaznaczyć w newsie, bo AMD zapewnia wzrost do 50%, z tym że może być mniejszy w zależności od karty jak i optymalizacji gier korzystających z nowych bibliotek. I ja wiem co napisałem, są o połowę szybsze, o połowę szybciej wykonują swoje obliczenia względem DX11 w pewnych okolicznościach, nie wiem może jeszcze dokładniej mam to wyłożyć? Ja najwyżej nie doprecyzowałem, a osoba pisząca tego newsa wprowadza ludzi w błąd, albo nie zna się na podstawach matematyki.

@asrudy|W moim przypadku (akademik) cena prądu nie ma znaczenia, poza tym 500 to nie mało, to faktycznie nie ta sama liga. Dużo ludzi zapewne skusiło by się na tańszą kartę, nawet jeżeli ciągnie więcej prądu.

Znając życie to Nvidia zaczęła już pracować nad rozwiązaniem problemu…

@asrudy 85Watów różnicy między 390x a 980 zwróci ci się może po 2 latach:) łał różnice w rachunku na prawdę poczujesz. powiem więcej gdybyś zrezygnował z kupna powiedzmy jednego batonika na dzień/wydania oólnie 2 zł dziennie oszczędność byłaby jeszcze większa niż efekt poboru prądu między obiema kartami:)

Mhm. To będzie jeszcze Volta, oraz AMD. Do tego nowe procki, które pewnie będą 3x mocniejsze niż te w konsolach. Po tym ceny starszego sprzętu spadną. Więc oby te przeklęte stare szroty konsolowe poszły sobie w cholerę. Może w końcu zaczną robić gry które wyglądają jak na 2016 rok. A nie na 2011.

Dobra janusz nie chce mi się z tobą męczyć nawet. Gdyby wszyscy w tym kraju tacy mądrzy i mocni byli w prawdziwym świecie, to by było pięknie.

Czekam na grę, który wywoła szok graficzny na skalę pierwszego Crysisa w roku 2007. Taki Wiedźmin 3 może i robi wrażenie, ale to już nie jest taki szok jaki wywołał widok Crysisa 8 lat temu.

@arisa321|Tak, Crysis i np. Race Driver: GRID zaszokowały mnie grafiką, a drugie takie coś odczułem niedawno, przy niektórych demach UE4. Takie coś byłoby fajnie zobaczyć w grach: https:www.youtube.com/watch?v=DFPOsnC_ETQ