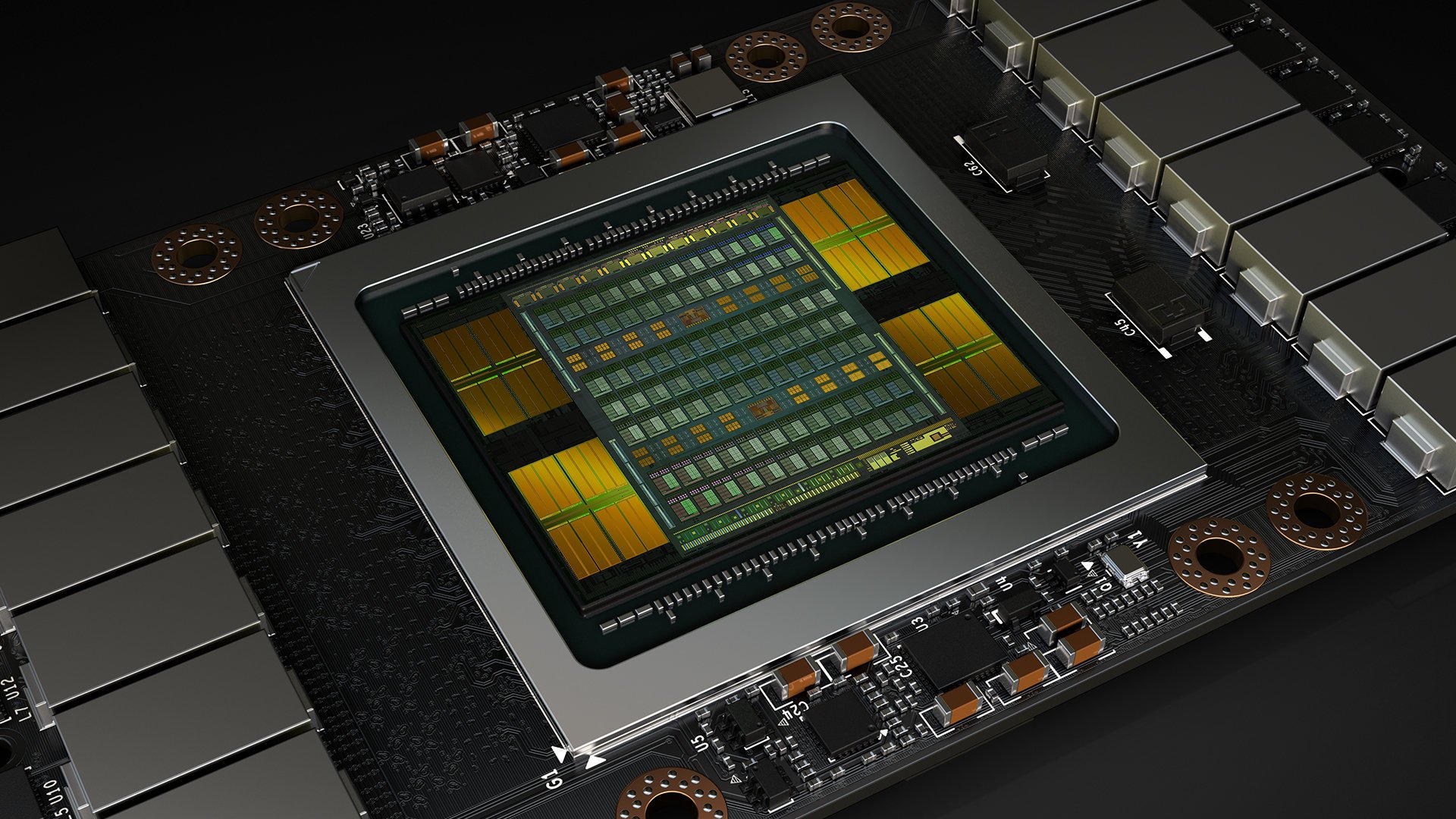

Nvidia pokazała Voltę i ujawniła jej parametry

Na początek parametry:

Co to oznacza z punktu widzenia gracza? Na razie nie wiadomo, bo pokazany chip trafi do przeznaczonych dla profesjonalistów kart Tesla. Z podanych powyżej parametrów wynika jedna, że w obliczeniach ma być od dwóch do nawet kilkunastu razy szybszy od poprzednika, przy czym największe zyski dotyczyć będą obliczeń związanych z sieciami neuronowymi (a więc i sztuczną inteligencją). Tutaj dzięki nowym rdzeniom Volta ma być ponad 10 razy szybsza!

A co z wydajnością w grach? Nvidia na razie o tym nie wspomina, można jednak próbować oszacować wydajność nowych kart, porównując liczbę rdzeni CUDA. GeForce GTX 1080 Ti ma ich 3584, Volta w pokazanej teraz wersji – 5120. Oznacza to wzrost o prawie 43% – oczywiście przy założeniu, że będą identyczne jak u poprzedników. Nvidia twierdzi jednak, że nowa karta ma być do 5 razy szybsza, jeśli chodzi o obliczenia matematyczne, co mocno sugeruje, że pojedyncze rdzenie CUDA też zostały usprawnione. I to również pod względem zapotrzebowania na energię, bo te wszystkie wzrosty udało się osiągnąć przy identycznym zużyciu prądu.

Trzeba jednak mieć na uwadze fakt, że nowy chip jest znacznie większy (815 mm2 vs 610 mm2), mimo iż wykonano go w nowszym procesie technologicznym (12 nm vs 16 nm). Większa powierzchnia chipu (jest o tyle ważna, że zależy od niej koszt produkcji) wynika między innymi z dodania rdzeni wykorzystywanych w obliczeniach związanych z AI (nazywają się Tensor Cores, jest ich 640 i w obliczeniach związanych ze sztuczną inteligencją mają wydajność 100 zwykłych procesorów – lub dziesięciu topowych GPU poprzedniej generacji). Pozostawienie ich w chipach przeznaczonych dla serii GeForce nie będzie miało sensu, więc całkiem możliwe, że „zwykłe” układy będą porównywalne pod względem wielkości (a więc i ceny) z tym, co znamy z obecnej generacji GeForce’ów.

Ostatnia sprawa to pamięć. Wykorzystanie HBM2 z jednej strony pozwala wykorzystać pełen potencjał chipu, z drugiej jest drogie. W kartach dla profesjonalistów nie ma to większego znaczenia, bo ich ceny i tak idą w tysiące dolarów. W GeForce’ach (nawet Titanach) Nvidia stosowała jednak dotychczas GDDR5 lub – w najmocniejszych wersjach – GDDR5X. (Jedynie AMD w swoich Fury miało pierwszą generację pamięci HBM, ale jak widać na przykładzie GeForce’ów serii 1000, nie jest ona potrzebna, by w grach uzyskać jak najwięcej fps-ów). Na horyzoncie są już jednak pamięci GDDR6, które mają oferować wydajność niewiele niższą niż HBM2 przy cenach porównywalnych z GDDR5. Co ciekawe, gdy jeden z ich producentów, SK Hynix, podawał ich parametry, wyglądały jak żywcem wzięte z GeForce’a 1080 Ti lub Titanów X.

A co z datą premiery nowych GeForce’ów? W przypadku obecnej generacji od prezentacji chipu do pokazania pierwszego GeForce’a, GTX 1080, minął zaledwie miesiąc. To by znaczyło, że seria 1100 pojawi się już w czerwcu! Problem w tym, że np. Samsung, jeden z producentów, którzy będą oferowali GDDR6, deklaruje, że chipy będą dostępne dopiero w 2018 roku.

Całkiem możliwe jednak, że GDDR6 trafi tylko do najmocniejszych GeForce’ów serii 1100, czyli GTX-ów 1180 Ti oraz Titanów. Zwykłe GTX-y 1180 i 1170 (a także wolniejsze) będą natomiast używały GDDR5 lub GDDR5X, które dostępne są bez problemów. Ich premiera może więc mieć miejsce choćby i w czerwcu. W końcu Volta to także dużo większa efektywność energetyczna, a przecież GeForce’y to nie tylko dedykowane karty graficzne do desktopów, ale również notebooków – a w nich niższe zapotrzebowanie na energię to nie tylko dłuższy czas pracy na baterii, ale również możliwość stworzenia cichszych, cieńszych modeli gamingowych.

I jeszcze jedno: warto pamiętać, że na przełomie maja i czerwca odbędzie się na Tajwanie Computex – a to właśnie tam 30 maja 2016 roku pokazano pierwsze GeForce’y GTX 1080. Czy i tym razem sytuacja się powtórzy? To okaże się już za niecałe 20 dni!

Czytaj dalej

19 odpowiedzi do “Nvidia pokazała Voltę i ujawniła jej parametry”

Dodaj komentarz

Musisz się zalogować, aby móc dodać komentarz.

Mój wewnętrzny entuzjasta technologiczny piszczy jak mała dziewczynka, ale wewnętrzny gracz jedynie ciężko wzdycha. GPU super, na pewno podbije rynek na kolejne lata (jak przed nim seria 900 i 1000), tylko po co? O ile ktoś nie ma ciśnienia na 4K i 60 FPS, to z nowego GPU użytku nie zrobi, za co w dużej mierze odpowiedzialne są słabowite konsole, trzymające developerów na technologicznej smyczy. Kto kilka lat temu zainwestował w niereferencyjnego GTX 980, tak na prawdę do dziś przesiadki robić nie musi.

Z drugiej strony, czy faktycznie potrzebujemy tutaj rewolucji? Czy poziom graficzny Wiedźmina 3 albo Battlefielda 1 nie jest wystarczający? Moim zdaniem faktycznym zmartwieniem jest brak świeżości i prawdziwych innowacji. Kontynuacje często są całkiem spoko, ale ile można wałkować to samo? Zwłaszcza PC cierpi na brak fajnych tytułów mogących w pełni wykorzystać jego (największy ze wszystkich platform) potencjał. PC bardzo potrzebuje swojego Sony lub MS. Aż dziw, że NVidia czy AMD o tym nie pomyślały…

To jest korporacja i ona ma zarabiać, a nie zastanawiać się, czy nie wypuścili przypadkiem zbyt mocnej technologii, żeby teraz się wstrzymywać i tracić wartość na rynku.

@RedCrow „za co w dużej mierze odpowiedzialne są słabowite konsole” Bardziej bym obwinił portfeli graczy. Co z tego, że komputery pozwalają na granie w 4K w 60 FPS, jak i tak mało kogo stać na taki sprzęt. Steam chyba kiedyś pokazywał, że posiadacze monitorów 4K to mniejszość.

Mam nadzieję, że 1070 stanieje bo potrzebuje dobrej karty do nowego kompa. AMD się Ryzenami spisało i mają mnie, ale GPU to muszą albo sobie odpuścić albo z ceny mocno spuścić. Problemy w grach i niższa wydajność niż prawie identyczny na papierze GTX, nie mówiąc o chu****** sterownikach.

@RadoxX – Oni się zastanawiać nad wypuszczeniem sprzętu nie muszą, ale konsument nad zakupem już i tak. I zrobi to na pewno, zwłaszcza gdy przyjdzie mu zapłacić za nowe GPU swoją miesięczną pensję… Jeżeli sprzętowcy nadal chcą zarabiać na graczach, to muszą im dać dobry powód do ciągłego osuszania swojego portfela. Dla kogoś, kto zdecydował się na zakup mocniejszej karty z serii 900 (a zwłaszcza tej z 1000), taki powód w tym momencie właściwie nie istnieje. Nawet najnowsze gry spokojnie chodzą na GTX 970.

@RedCrow Jedna prosta odpowiedź – VR. Żeby to wyglądało w miarę przyzwoicie to potrzeba okularów z rozdziałką 4K i to w 80 – 100 kl/s. No i oczywiście potrzebne są dwa takie obrazy. A z tym pewnie nie poradzi sobie jeszcze nowa generacja, nie wspominając o tym, że rozdzielczości będą rosły bo akurat tutaj 8K czy 16K będzie miało sens.

@arturdzie – Krótko – casus Crysisa. W dniu premiery niewielu mogło go zobaczyć w pełnej krasie, bo niezbędny sprzęt kosztował krocie, przy czym gra dobrze się skalowała na słabszych PCtach. Było to możliwe, bo Crysis był PCtowym exem i twórcy zrobili swoje, nie musząc iść na kompromisy. Tytuły multiplatformowe projektuje się natomiast z myślą o najsłabszej platformie, potem trochę je upiększając. PC nie rozwinie skrzydeł bez dużych gier na wyłączność. Konsole to dla niego taki sprzętowy kamień u nogi.

Fp64 pewnie zablokują dla użytkownika domowego(jak w pascalu (do gier to się nie przydaje), a tensor core trafi tylko do tesli (w celu uczenia maszynowego). Kolejna generacja kart graficznych i kolejna generacja niedorobionych gier z zawyżonymi cenami.

Potrzebne są dużo mocniejsze karty tu i teraz właśnie ze względu na VR i coraz większe parcie na granie w 120FPS. Oprócz tego obecne karty są trochę za słabe jeśli chodzi o renderery GPU – nowe karty w rozsądnej cenie sprawią, że renderowanie GPU będzie bardziej opłacalne i sporo ludzi w tym siedzących może to skusić…

Buuu a 7 miesięcy temu kupiłem komputer z GTXem 1070 i do dziś, do czasu przeczytania tego newsa, byłem święcie przekonany o trafności decyzji:P a na serio, to wiem, że technologia idzie naprzód, jednak sądziłem, że od premiery 10×0 do premiery kolejnych układów minie raczej 2 lata…troszkę dziwna ta polityka, na razie GTX 1070 jeszcze na niczym się nie zdyszał…Może ktoś wyjaśni, skąd wzięła się tak szybka zapowiedź debiutu nowych kart? Pytam poważnie, aż tak nie śledzę tematu…

Raczej tak szybko nie wydadzą, najprędzej spodziewałbym się sierpień/wrzesień. Co prawda niedługo AMD wyda swoje karty jednak będą one wydajnością dorównywały GTX1070/1080 (w zależności od wersji) więc Nvidia nie musi na nie odpowiadać. Volta będzie konkurować z kolejną generacją od AMD, a te wyjdą pod koniec roku lub następnym. W dodatku Nvidia chce w topowych dać GDDR6 więc pierw wyjdą mid/low end, ewentualnie w nowym roku razem z high end.

Dziwi mnie po co zmieniali na 12nm jak nawet zmniejszenie powierzchni wynosi zaledwie 5%?? Ta generacja będzie w cholerę droga. Poza tym bez tych jednostek tensorowych których raczej do growych kart nie dadzą, to nie będzie znacznych rozwiązań z których gry by skorzystały.

@bowmanek racja tylko, że mogliby to zrobić na 10 nm bo przynajmniej mogły być mniejsze procki a tak to ceny z tym GDDR6 i HBM2 będą w cholere wysokie. 600mm2 TitanV może już kosztować więcej niż te 1200$.

Te 12 nm FinFET to tak naprawdę tylko solidnie usprawnione 16 nm FinFET, nie zupełnie nowa litografia. No cóż… 🙂

Wojtas nie wiem gdzie ty żyjesz, ale nVidia co roku trzaska nowe karty, bo kasa się musi zgadzać. Prawie rok temu (początek czerwca) kupiłem moją 1080 wiedząc, że za rok będę mógł brać 1180

Tennessee właśnie czas między premeirą 9- setek a kart z 1000 w nazwie wynosił 2 lata, tutaj mamy natomiast circa rok. Potrafię zrozumieć, że chodzi o pieniądze, jednak nie widzę praktycznego zastosowania nowych technologii wśród masowych graczy. Czyżby na rynku panowała tak wielka ufność w rozwój VR ? Wszak VR jest dopiero rozwijającym się projektem. Nowe układy spowodują też kolejny rozdźwięk między konsolami a blaszakami (nawet przy PS4 pro czy project scorpio, różnice będą diametralne).

Dziwna polityka. Dodam, że na moim GF 1070 nic mi się jeszcze nie przycinało. Podejrzewam, że w znakomitej większości przypadków także GTX 970 jest trudny do zajechania w obecnych czasach. Ktoś tua na forum mądrze napisał, że decyzja należeć będzie do klientów. Generalnie zawsze lepiej jest mieć wybór (nawet, jeśli roznosi się o wybór między 60 a 120 klatek w QHD), niż go nie mieć. Tym niemniej, wracając do meritum mojego postu sprzed kilku dni, kupując kompa niedawno liczyłem na dłuższy status high endu 🙂

Największą zaletą nowych kart będzie lepsza obsługa sieci neuronowych, te karty bardziej są potrzebne twórcom i deweloperom niż graczom. Za ~ 7 lat będą już w każdym kompie i konsoli i pewnie nowe oblicze AI w grach ujrzymy